Fusión inteligente de actores locales en entornos remotos

El piloto de fusión inteligente de actores locales en entornos remotos propone un escenario donde se muestran las oportunidades que las nuevas funcionalidades de las redes 5G ofrecen a la producción de contenidos de alta calidad cuando se pueden garantizar una elevada velocidad binaria en ambos sentidos de transmisión a la vez que una latencia mínima controlada. Así, se plantea la fusión de un contenido local dinámico sobre un escenario (i.e. fondo) diferente. El piloto considera varios retos tecnológicos. Por un lado, la combinación de ambos contenidos para obtener un resultado de alta calidad requiere una latencia mínima y controlada. Además, se necesitan esquemas avanzados de compresión de vídeo con retardo mínimo que implican nuevos esquemas de control de flujo y, por lo tanto, de control del buffer del codificador. Aunque lo expuesto ya implica un reto

que solamente se puede resolver con el empleo de redes 5G, el piloto incluye un subsistema de vídeo con punto de vista libre en tiempo real para la obtención de contenido visual de los actores. Así, se requiere la disponibilidad de redes con una gran capacidad de up-link, por lo que el piloto inicia el camino a las redes 6G.

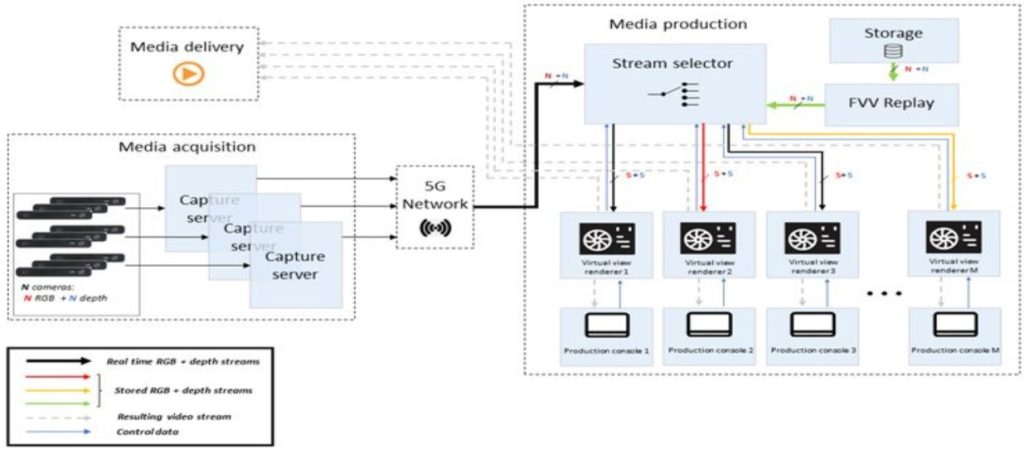

Las actividades consideradas comienzan con la definición del escenario del piloto y de los requisitos operacionales del mismo. Así, se considera FVV Live que es un sistema de video de punto de vista libre extremo a extremo, de baja latencia y en tiempo real que incluye captura, transmisión, síntesis en un servidor de borde y visualización y control en un terminal móvil. El subsistema de adquisición incluye: cámaras de consumo estéreo, que no requieren genlock, sincronización software sobre una fuente de reloj compartida distribuida mediante PTP (IEEE 1588-2002) y segmentación y estimación de profundidad en tiempo real para permitir la síntesis en capas y el ahorro de ancho de banda. El subsistema de transmisión incluye: codificación en tiempo real de todas las transmisiones de cámara (necesarias), tanto en color como en profundidad, transmisión RTP, codificación sin pérdidas de la información de profundidad que se requiere en la síntesis mediante la adaptación de estructuras de video 4:2:0 para obtener 12 bits por píxel. El subsistema de síntesis solo utiliza las cámaras más cercanas al punto de vista virtual, emplea un modelo de fondo denso precalculado con Retinex + AKAZE + SfM + MVS y aplica síntesis en capas para integrar el modelo de fondo anterior con un primer plano en vivo.

El piloto considera la integración del sistema FVV Live en la infraestructura de comunicaciones que se instalará en la ETS Ingenieros de Telecomunicación y, además, incorpora la funcionalidad de fusión inteligente del primer plan de los actores locales con el fondo proveniente de un escenario remoto. Se requiere disponer de canales up-link con capacidad suficiente para varios flujos de textura y profundidad de las cámaras más cercanas al punto de vista virtual, de comunicaciones ultra fiables de baja latencia y de funciones de virtualización de red como las capacidades ofrecidas por los MEC.