Producción remota de contenidos digitales

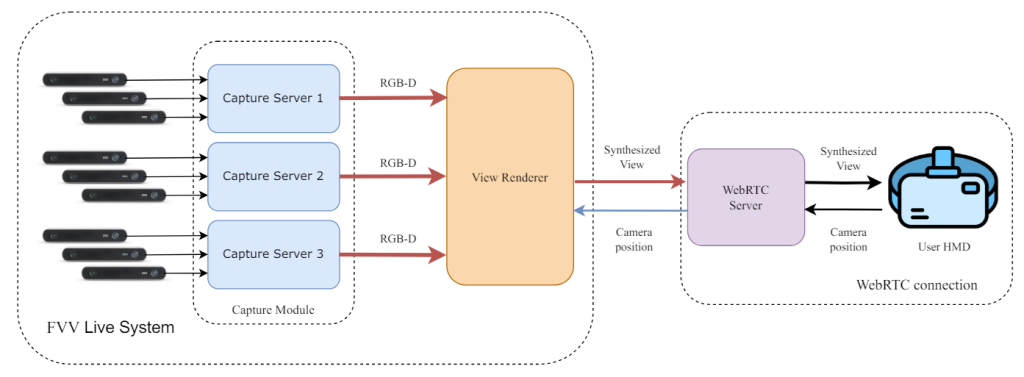

La actividad del piloto de producción remota, cuyo objetivo es proporcionar a radiodifusores mecanismos que les permitan la producción remota de contenidos mediante redes 5G/6G, por ejemplo de eventos en vivo, actualmente usando redes dedicadas o bien redes cableadas ad-hoc, que tienen un gran coste en su despliegue, y poca versatilidad.

- MPE: Mezclador/Conmutador de video (mixer).

- vCE: Motor de comprensión y adaptación de contenido multimadia.

- Optimización basada en aprendizaje de refuerzo y análisis de contenido.

- Contribución mediante red 5G (Inalámbrica).

La actividad del piloto comienza con la definición de los requisitos y los sistemas de emisión en:

-

- La parte de la transmisión desde las cámaras de captura de la información, tanto conectadas a un módem 5G/6G como desde un terminal directamente.

- El MEC de la red Core, cerca de la parte de acceso radio a utilizar.

En la parte del MEC, se implementará el desarrollo de funciones virtualizadas, de manera que se puedan procesar las señales multimedia recibidas (mezcla, metadatación, codificación), y enviarlas al resto de la red con una calidad de contribución, que permita más adelante su posterior proceso remoto. Para asegurar la calidad es necesario el desarrollo de algoritmos inteligentes para configurar la capacidad de red requerida por los servicios y optimizar el rendimiento mediante el procesamiento en el borde de la red, así como medir la calidad de la señal resultante. Por último, se realizará una integración, y unas pruebas funcionales de validación, mediante una prueba de campo real que permita probar el piloto en condiciones reales, y aumente el impacto que se espera del mismo.

Resultados Preliminares

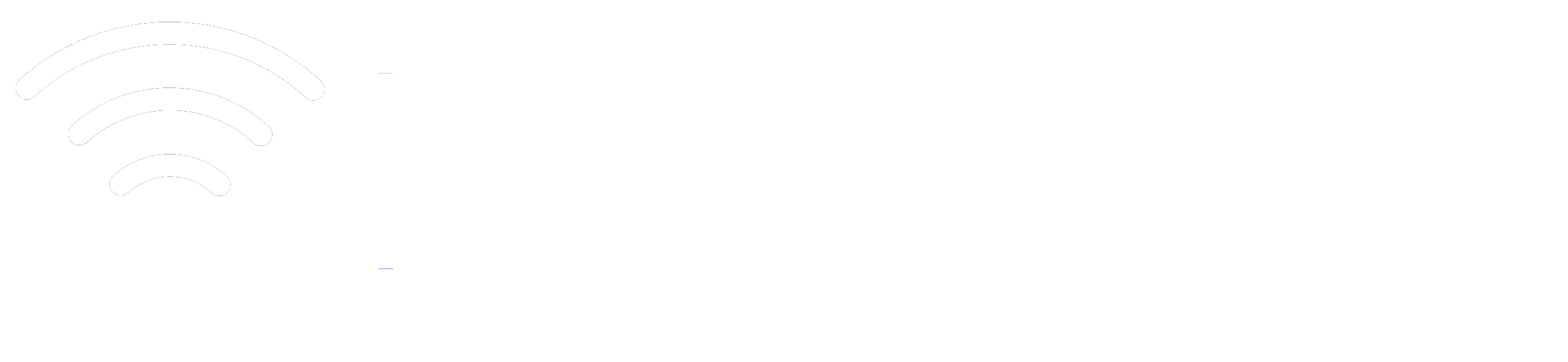

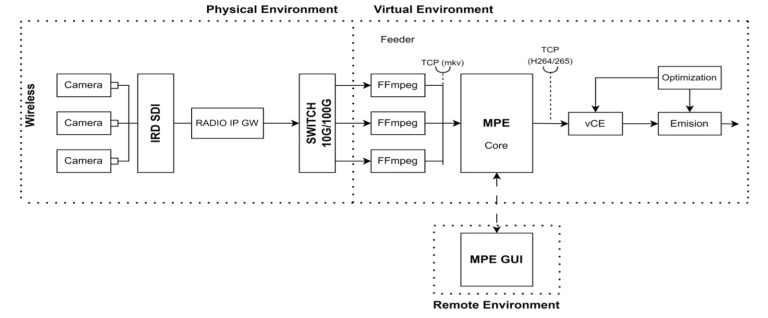

The recent development of new video capture systems has led to the adoption of volumetric video technologies to replace 2D video in use cases such as videoconference, where this enhancement promises to solve videoconference fatigue. In particular, volumetric capture allows the content to be viewed from different points of view, enabling more natural interaction during the videoconference. One of the solutions proposed for this scenario is Free Viewpoint Video (FVV). It makes use of a set of calibrated cameras that allows the use of real life information to generate a synthetic view from any arbitrary point in space. Although there are real-time capture developments of FVV systems, they make use of 2D displays and joysticks to control the point of view. In our opinion, this undermines the possibilities of volumetric video for the videoconferencing use case. Building on a previously developed FVV system, we present a novel untethered HMD-based immersive visualization system that enables point of view control with the user’s natural position and visualization of live volumetric content in a 3D environment. Synthetic views are generated in real-time by the FVV system, and streamed with low latency protocols to a Meta quest 3 HMD using a WebRTC-based server. This work discusses the architecture of the end-to-end system and describes the bitrate, framerate and latency values at which the system works.